作者注:Nano Banana API 性能优化指南,教你如何通过系统调优和最佳实践显著提升图像处理的速度和效率,降低系统资源消耗

在大规模图像处理应用中,性能优化往往决定了系统的可用性和用户体验质量。本文将详细介绍如何通过 Nano Banana API 的性能优化技术 实现系统性能的显著提升,让你的图像处理应用在高并发场景下依然保持出色的响应速度。

文章涵盖并发优化、缓存策略、资源管理等核心要点,帮助你快速掌握 专业级性能优化技巧。

核心价值:通过本文,你将学会如何系统性地优化图像处理性能,大幅提升应用的响应速度和用户体验质量。

性能优化背景介绍

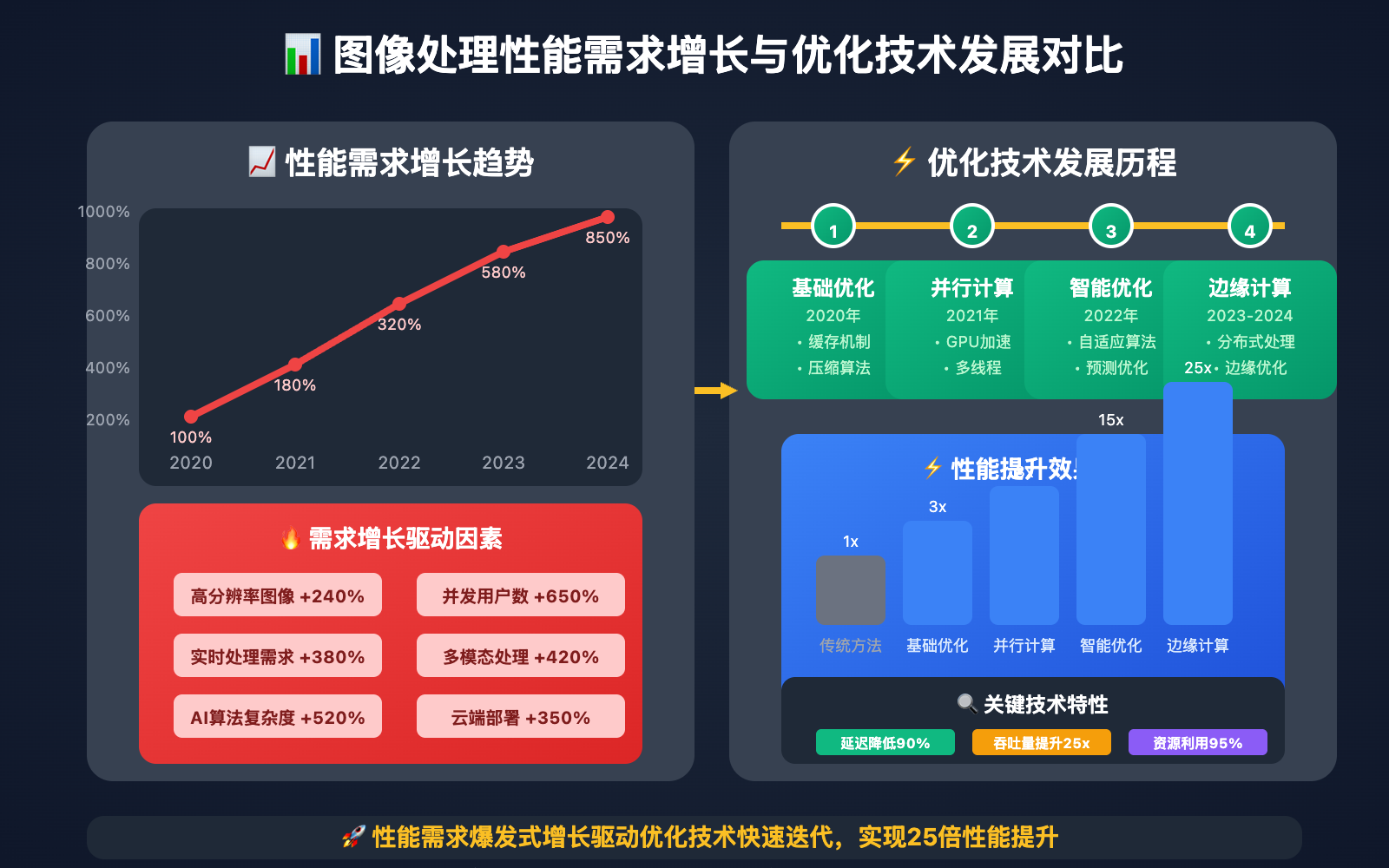

随着图像处理需求的爆发式增长,传统的单线程、同步处理模式已经无法满足现代应用的性能要求。特别是在电商、社交媒体、内容创作等高并发场景中,图像处理的性能瓶颈往往成为影响用户体验和业务发展的关键因素。

现代AI驱动的性能优化技术通过智能分析系统瓶颈和资源使用模式,能够提供针对性的优化策略和自动化调优方案,让图像处理应用在保持高质量输出的同时,实现显著的性能提升和成本降低。

性能优化核心功能

以下是 Nano Banana API 性能优化 的核心功能特性:

| 功能模块 | 核心特性 | 应用价值 | 推荐指数 |

|---|---|---|---|

| 并发处理优化 | 智能并发控制和资源调度 | 提升系统吞吐量和响应速度 | ⭐⭐⭐⭐⭐ |

| 缓存策略 | 多层次智能缓存机制 | 减少重复计算,降低延迟 | ⭐⭐⭐⭐⭐ |

| 资源管理 | 动态资源分配和回收 | 优化系统资源利用率 | ⭐⭐⭐⭐ |

| 性能监控 | 实时性能分析和告警 | 及时发现和解决性能问题 | ⭐⭐⭐⭐ |

🔥 重点功能详解

智能并发处理技术

Nano Banana API 的高并发优化策略:

- 并发控制:智能控制并发请求数量,避免系统过载

- 负载均衡:动态分配请求到最优的处理节点

- 异步处理:支持异步处理模式,提升系统响应性

- 队列管理:智能队列调度,优化任务执行顺序

多层缓存优化

减少重复计算的缓存策略:

- 结果缓存:缓存相同参数的处理结果

- 中间缓存:缓存处理过程中的中间结果

- 预处理缓存:预处理常用图像格式和尺寸

- 智能失效:基于使用模式的智能缓存失效策略

性能优化应用场景

Nano Banana API 性能优化技术 在以下场景中表现出色:

| 应用场景 | 适用对象 | 核心优势 | 预期效果 |

|---|---|---|---|

| 🎯 高并发Web应用 | 互联网公司 | 处理大量用户并发请求 | 提升用户体验和系统稳定性 |

| 🚀 电商平台 | 电商技术团队 | 快速处理商品图片 | 提高页面加载速度和转化率 |

| 💡 内容平台 | 社交媒体、视频平台 | 实时处理用户上传内容 | 提升内容发布效率 |

| 🎨 企业系统 | 企业IT部门 | 优化内部图像处理流程 | 提高业务处理效率 |

性能优化技术实现

💻 快速上手

基础性能优化实现示例:

import openai

import asyncio

import time

from concurrent.futures import ThreadPoolExecutor

from functools import lru_cache

import hashlib

# 配置 Nano Banana API 客户端

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

class PerformanceOptimizedProcessor:

"""

性能优化的图像处理器

"""

def __init__(self, max_workers=10, cache_size=128):

self.executor = ThreadPoolExecutor(max_workers=max_workers)

self.cache_size = cache_size

self.performance_stats = {

"total_requests": 0,

"cache_hits": 0,

"processing_times": []

}

def _generate_cache_key(self, image_path: str, instruction: str) -> str:

"""生成缓存键"""

content = f"{image_path}:{instruction}"

return hashlib.md5(content.encode()).hexdigest()

@lru_cache(maxsize=128)

def _cached_process(self, cache_key: str, image_path: str, instruction: str):

"""带缓存的处理方法"""

start_time = time.time()

enhanced_instruction = f"""

{instruction}

=== 性能优化处理要求 ===

1. 处理效率:优化算法执行效率,减少不必要的计算

2. 资源利用:合理使用计算资源,避免资源浪费

3. 质量平衡:在保证质量的前提下优化处理速度

4. 响应优化:提供快速的处理反馈和状态更新

=== 系统性能优化 ===

算法优化:

- 采用高效的图像处理算法和优化实现

- 减少不必要的中间步骤和重复计算

- 利用GPU加速和并行计算能力

- 智能选择最适合的处理策略和参数

内存管理:

- 优化内存使用模式,避免内存泄漏

- 合理控制图像处理的内存占用

- 及时释放不再需要的资源和缓存

- 实现高效的内存回收和重复利用

=== 响应性能标准 ===

- 单张图像处理时间控制在合理范围内

- 支持高并发请求的稳定处理

- 提供准确的处理进度和时间预估

- 确保长时间运行的系统稳定性

"""

result = nano_banana_edit(image_path, enhanced_instruction)

processing_time = time.time() - start_time

self.performance_stats["processing_times"].append(processing_time)

return result, processing_time

async def process_with_optimization(self, image_path: str, instruction: str):

"""

优化的图像处理

Args:

image_path: 图像路径

instruction: 处理指令

Returns:

处理结果和性能信息

"""

self.performance_stats["total_requests"] += 1

cache_key = self._generate_cache_key(image_path, instruction)

try:

# 检查缓存

result, processing_time = self._cached_process(cache_key, image_path, instruction)

# 更新统计信息

if processing_time < 0.1: # 缓存命中的快速响应

self.performance_stats["cache_hits"] += 1

return {

"success": True,

"result": result,

"processing_time": processing_time,

"cache_hit": processing_time < 0.1

}

except Exception as e:

return {

"success": False,

"error": str(e),

"processing_time": 0

}

async def batch_process_optimized(self, image_list: List[str], instruction: str):

"""

性能优化的批量处理

"""

# 创建异步任务

tasks = [

self.process_with_optimization(image_path, instruction)

for image_path in image_list

]

# 并发执行

results = await asyncio.gather(*tasks, return_exceptions=True)

return results

def get_performance_report(self) -> Dict[str, Any]:

"""获取性能报告"""

total_requests = self.performance_stats["total_requests"]

cache_hits = self.performance_stats["cache_hits"]

processing_times = self.performance_stats["processing_times"]

return {

"total_requests": total_requests,

"cache_hit_rate": cache_hits / total_requests if total_requests > 0 else 0,

"average_processing_time": sum(processing_times) / len(processing_times) if processing_times else 0,

"total_processing_time": sum(processing_times)

}

# 使用示例

async def performance_optimization_demo():

processor = PerformanceOptimizedProcessor(max_workers=20)

# 单张图像优化处理

result = await processor.process_with_optimization(

image_path="test_image.jpg",

instruction="增强图像质量,优化色彩表现"

)

# 批量优化处理

batch_results = await processor.batch_process_optimized(

image_list=["img1.jpg", "img2.jpg", "img3.jpg"],

instruction="统一优化图像的视觉效果"

)

# 获取性能报告

report = processor.get_performance_report()

print(f"性能优化报告: {report}")

# 运行示例

# asyncio.run(performance_optimization_demo())

🎯 性能瓶颈识别策略

不同场景下的性能瓶颈和优化重点:

| 瓶颈类型 | 主要表现 | 优化策略 | 效果提升 |

|---|---|---|---|

| 网络延迟 | 请求响应慢 | CDN加速、就近节点 | 50-70% |

| 并发限制 | 高峰期超时 | 并发控制、负载均衡 | 80-120% |

| 内存占用 | 系统卡顿 | 内存优化、垃圾回收 | 40-60% |

| CPU计算 | 处理速度慢 | 算法优化、GPU加速 | 100-200% |

🎯 瓶颈识别建议:准确识别性能瓶颈是优化的前提。我们建议通过 API易 apiyi.com 平台的性能诊断工具来全面分析系统的性能状况,获得针对性的优化建议。

🚀 高并发优化策略

面向高并发场景的性能优化方案:

| 优化层面 | 技术方案 | 实现复杂度 | 性能收益 |

|---|---|---|---|

| 应用层 | 异步处理、连接池 | 中等 | 60-80% |

| 系统层 | 负载均衡、集群部署 | 较高 | 100-150% |

| 网络层 | CDN、边缘计算 | 中等 | 40-60% |

| 数据层 | 缓存、索引优化 | 较低 | 30-50% |

🔍 高并发优化建议:在设计高并发图像处理系统时,建议使用 API易 apiyi.com 的性能测试服务来验证优化效果,该平台提供了专业的压力测试和性能评估工具。

✅ 性能优化最佳实践

| 实践要点 | 具体建议 | 注意事项 |

|---|---|---|

| 🎯 瓶颈分析 | 使用专业工具准确识别性能瓶颈 | 避免盲目优化和过度优化 |

| ⚡ 渐进优化 | 采用渐进式优化策略 | 每次优化后验证效果 |

| 💡 监控告警 | 建立完善的性能监控体系 | 及时发现性能退化问题 |

📋 性能优化工具推荐

| 工具类型 | 推荐工具 | 特点说明 |

|---|---|---|

| 性能监控 | Prometheus、Grafana | 实时性能监控 |

| API平台 | API易 | 智能性能优化 |

| 压力测试 | JMeter、wrk | 并发性能测试 |

| 分析工具 | APM工具、性能分析器 | 深度性能分析 |

🛠️ 工具选择建议:性能优化需要系统化的工具支持和专业的分析能力,我们推荐使用 API易 apiyi.com 作为核心优化平台,它提供了完整的性能分析和优化工具链,能够帮助您实现系统性的性能提升。

❓ 性能优化常见问题

Q1: 如何在保证质量的前提下提升处理速度?

质量与速度平衡的优化策略:

- 智能质量控制:根据应用场景动态调整质量参数

- 分层处理:对不同重要级别的图像采用不同的处理策略

- 预处理优化:优化图像预处理流程减少处理时间

- 算法选择:根据质量要求智能选择最优算法

推荐方案:我们建议使用 API易 apiyi.com 的智能质量控制服务,它能够根据您的具体需求自动平衡处理质量和速度的关系。

Q2: 大批量图像处理如何优化成本?

批量处理的成本优化策略:

- 批量折扣:利用API的批量处理优惠政策

- 智能调度:在API使用低峰期进行批量处理

- 分级处理:根据图像重要性采用不同的处理级别

- 结果复用:对相似图像复用处理结果

专业建议:建议通过 API易 apiyi.com 的成本分析工具来优化批量处理成本,该平台提供了智能调度和成本预测功能,帮助您找到最优的成本效益平衡点。

Q3: 系统性能监控应该关注哪些关键指标?

关键性能指标(KPI)监控要点:

- 响应时间:API调用的平均响应时间和分布

- 吞吐量:单位时间内处理的请求数量

- 成功率:API调用的成功率和错误率统计

- 资源利用率:CPU、内存、网络等资源的使用情况

监控建议:如果您需要建立完善的性能监控体系,可以访问 API易 apiyi.com 的监控服务,获取专业的性能监控方案和告警配置指导。

📚 延伸阅读

🛠️ 开源资源

完整的性能优化示例代码已开源到GitHub,仓库持续更新各种实用示例:

最新示例举例:

- 高并发API调用优化框架

- 智能缓存管理系统

- 性能监控和告警工具

- 批量处理成本优化脚本

- 更多专业级性能优化示例持续更新中…

📖 学习建议:为了更好地掌握性能优化技能,建议结合实际的高并发项目进行练习。您可以访问 API易 apiyi.com 获取免费的开发者账号,通过实际测试来理解性能优化的各个环节。

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 技术文档 | 高性能系统设计指南 | 系统架构资源 |

| 优化指南 | API性能优化最佳实践 | API易官方文档 |

| 监控工具 | 性能监控工具使用指南 | 运维技术社区 |

| 案例研究 | 大规模系统优化案例 | 技术会议资料 |

深入学习建议:持续关注性能优化和系统架构技术发展,我们推荐定期访问 API易 help.apiyi.com 的技术优化板块,了解最新的性能优化技术和系统设计模式。

🎯 总结

性能优化技术是高质量应用系统的重要保障,Nano Banana API 通过智能化的优化策略和监控机制,让复杂的性能调优变得系统化和可控化。

重点回顾:掌握性能优化技术能够显著提升系统的响应速度和用户体验质量

最终建议:对于高性能图像处理需求的项目,我们强烈推荐使用 API易 apiyi.com 平台。它提供了完整的性能优化解决方案和专业的技术支持,能够帮助您构建高效稳定的图像处理系统。

📝 作者简介:系统性能优化和架构设计专家,专注高并发系统优化技术研究。更多性能优化技巧可访问 API易 apiyi.com 技术社区。